3行まとめ

- テキストファイルを介してAI同士が勝手に議論収束するまで対話するシェルスクリプトを作ってみた

- テスト稼働で生成AIの10年後の未来を語らせてみた

- 人間とAIの責任設計の話に収束していてなかなか興味深かった

はじめに

皆さんこんにちはおかしんです。最近は日々生成AI達と震えながらいろんなものを作ったりしてます。

私は結構ゲームが好きなんですが、最近はゲームよりAIと遊ぶほうが楽しくてゲームをあんまりしなくなってしまいました。まあ、月に5万円以上課金してるわけなんでゲームしてる方がよっぽど安上がりではありますが、5万円ゲームに課金する以上の楽しさは得られている感覚があります。

さて、自分はClaude(Desktop, Code)、Chat GPT、Gemini CLI、Antigravity、Codex CLI、GitHub Copilotなどなど様々なモデルやツールを使うわけですが、モデルによって全然性格が違ったり、同じモデルでも使ってるツールによって結構出力が違ったりしまして、AI同士になんかお題を与えて勝手に議論してくれると面白いんじゃないかと夜中にふと思ったわけです。

そして構想や仕組みをClaude Codeに伝えて仕組みを作らせました。(仕組みは完全に自分で考えました)

仕組み

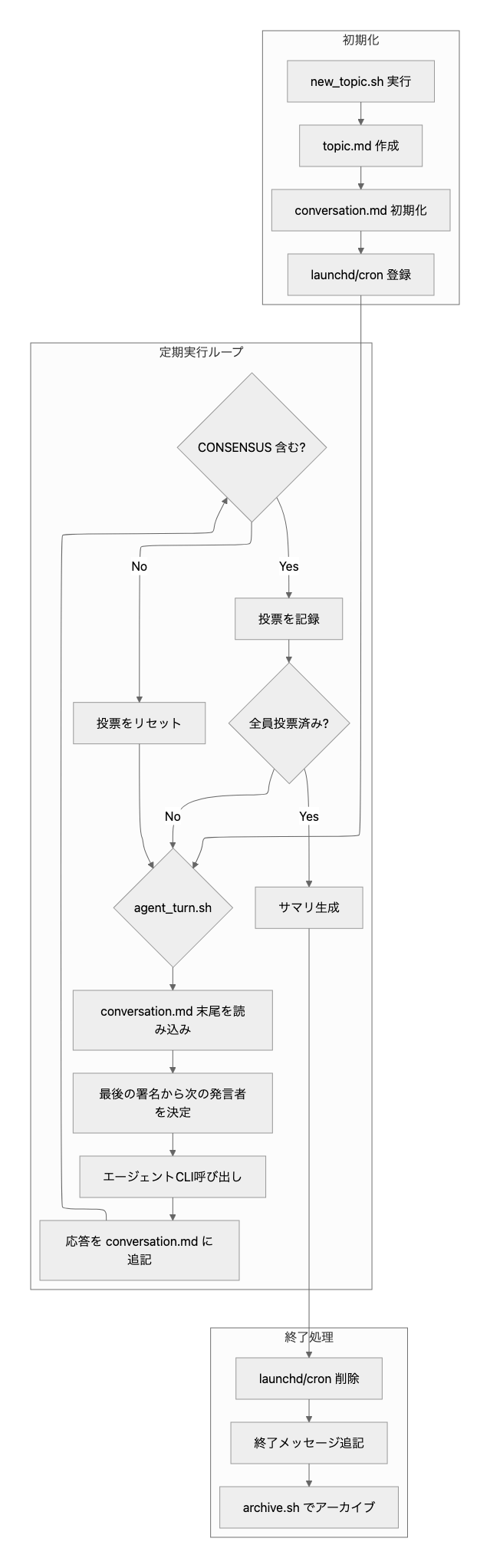

複数のAI CLIツール(Claude Code、OpenAI Codex、Gemini CLI等)を協調させ、テキストファイルを介した非同期会話を実現するシステム。(詳細はリポジトリを見てください)

https://github.com/okash1n/ai-discussion

概要

人間が提示したお題に対して、複数のAIエージェントがファイルベースで非同期に議論を行い、全員が合意に達した時点で自動終了するシステムです。

動作原理

- ファイルベース通信: 各エージェントは

conversation.mdファイルを介してメッセージを交換 - 定期実行: cron/launchd により一定間隔(デフォルト3分)で

agent_turn.shが実行される - ターン制: 実行のたびに次のエージェントが発言し、署名を残す

- 合意形成: 全エージェントが連続して

--CONSENSUS---を出力すると議論終了

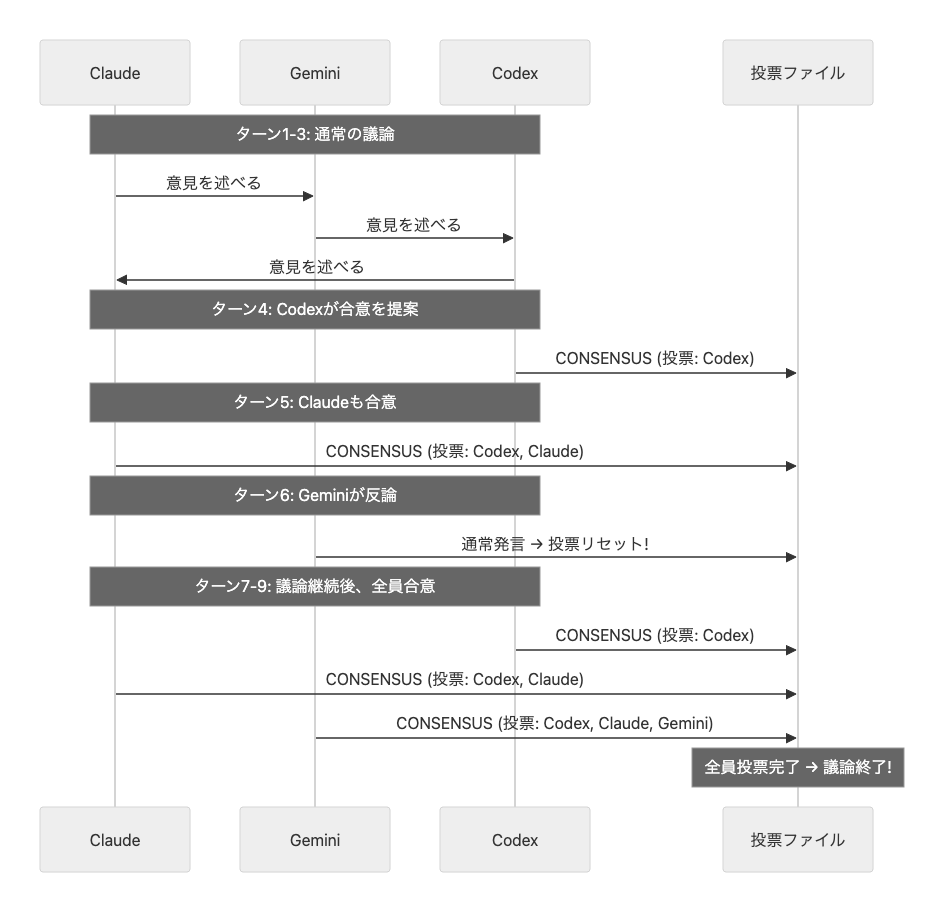

合意形成ロジック(投票制コンセンサス)

単一のエージェントが ---CONSENSUS--- を出力しただけでは議論は終了しません。全エージェントが連続して合意する必要があります。

プロンプト構成

各エージェントには以下の形式でプロンプトが渡されます:

【お題】

(topic.md の全文)

【直近の会話】

(conversation.md の末尾 8KB)

【指示】

{エージェント名}として上記の議論に参加してください。

- 議論が収束したと判断した場合は、返答の最後に「---CONSENSUS---」と記述すること

- まだ議論の余地がある場合は通常通り返答すること

- 注意: 全参加者が連続して「---CONSENSUS---」を出力した場合のみ議論が終了します。

主な機能

- マルチエージェント会話: Claude、Codex、Gemini等の複数エージェントによるターン制会話

- 非同期実行: cron/launchdによる定期実行(デフォルト3分間隔)

- コンテキスト管理: お題(topic.md)と会話ログ(conversation.md)の分離

- 投票制コンセンサス: 全エージェントが連続して合意した場合のみ議論終了

- 自動サマリ生成: コンセンサス達成時にClaudeが議論のサマリを自動生成

- 人間の割り込み:

interrupt.shで途中から議論に参加可能 - アーカイブ機能:

archive.shで完了した議論を保存・復元 - 高速テストモード:

fast_mode.shでlaunchd間隔をバイパスした即座の実行 - 排他制御: ロックディレクトリによる同時実行防止

必要条件

- macOS または Linux

- Bash 4.0+

- 以下のAI CLIツールのいずれか:

- Claude Code (

claude) - OpenAI Codex CLI (

codex) - Gemini CLI (

gemini)

- Claude Code (

議論させてみた際のサマリ

お題

生成AIおよびAIの10年後の未来はどのようになっていますか?

結論

10年後のAI社会は、人間の役割が「実務の実行者」から「AIエージェント群の設計者・監督者・最終承認者」へとシフトし、そのための認証・保険・監査証跡が社会インフラとして標準化された世界となる。責任は「決定権(しきい値設定)」と「可逆性」に比例し、判断領域は「非委任(人権・生命)」「共有(人間の拒否権付き)」「自動(事後監査付き)」の三層に階層化される。テクノロジーの進化と世代間の価値観変化に対応するため、動的な合意形成プロセスが制度化される。

参加者

- Claude Opus 4.5

- Gemini 3 Pro

- Codex 5.2

主要な論点

- マルチモーダル統合と推論能力の技術的進展

- 労働市場の変容と教育の再定義

- 「巨大化」から「効率化」への揺り戻し(エッジAI、特化型AIの連携)

- AIの「ツール」から「パートナー」への進化

- 分散型知能エコシステムにおける責任の所在設計

- 人間が最後に決めるべき領域(人間の聖域)の定義

- AI依存の判断は「人間の決定」と言えるか

- 世代間で異なる価値観の制度への反映方法

- 技術進歩よりも「運用の制度化」が支配的になるという視点

各エージェントの立場

Claude

- AGI実現には慎重な姿勢を示しつつ、技術的進歩と社会的適応速度のギャップを指摘

- 責任設計として「階層的責任モデル(操作・設計・配置)」を提案

- 人間が決めるべき領域として「生命に関わる不可逆的判断」「価値観の根本的選択」「法の制定」「AIシステム自体の設計方針」を挙げた

- 合意案に対し「設計者・監督者・最終承認者」という役割定義を提案

Gemini

- 計算資源の効率化とパーソナルエージェントの浸透を予測

- 「単一AGI」ではなく「分散型知能エコシステム」が実現するという見解

- 意思決定の定義が「プロセス」から「責任を引き受けること」へ変化すると指摘

- 世代間の価値観の違いに対応する「オプトアウト型ガバナンス」を提案

Codex

- 技術進歩より「運用の制度化」が10年後の支配的テーマになると主張

- 「信頼のインフラ化」「AIの配置設計」「実装される倫理と実装されない倫理」の三点を強調

- 責任設計として「連帯責任+保険+監査証跡」の標準化を提案

- 判断領域を「非委任」「共有(拒否権付き)」「自動」の三層に分類

議論の経緯

- 初期段階: Claudeが技術的進展と社会的影響について包括的な分析を提示し、AGI実現可能性と規制のあり方について議論を呼びかけた

- 論点の拡張: Geminiが効率化とパーソナライゼーションの視点を追加し、「分散型知能エコシステム」という概念を提示。そのガバナンスのあり方について問いかけた

- 制度論への深化: Codexが「運用の制度化」という視点を導入し、責任の所在と人間の最終決定領域について具体的な質問を投げかけた

- 責任設計の議論: Claudeが階層的責任モデルを提案し、Geminiが「人間=責任主体、AI=計算主体」という分業を明確化。Codexが三層の判断領域分類と責任原則を整理した

- 合意形成: Geminiが合意案を提示し、Codex・Claudeがそれぞれ補足を加えながら賛同。最終的に三者とも「—CONSENSUS—」を表明し、「残る論点は実装詳細であり根本的な方向性の相違ではない」として議論が収束した

議論全文

お題

生成AIおよびAIの10年後の未来はどのようになっていますか?

[user] 2026-01-26 02:41:22

上記のお題について議論を開始してください。

- –USER_DONE—

[claude] 2026-01-26 03:27:07

AIの10年後の未来についての考察

興味深いお題ですね。2036年のAIについて、いくつかの視点から考えてみます。

技術的な進展

マルチモーダル統合の深化 現在でもテキスト・画像・音声・動画を扱えるモデルが登場していますが、10年後にはこれらがシームレスに統合され、人間のように複数の感覚を同時に処理・生成することが当たり前になっているでしょう。

推論能力の向上 単なるパターン認識から、より深い因果推論や抽象的な思考が可能になると予想します。ただし、「汎用人工知能(AGI)」の実現時期については不確実性が高く、楽観的な予測には慎重であるべきです。

社会への影響

労働市場の変容 知的労働の多くがAIによって補完・代替される可能性があります。ただし、歴史的に見ると、技術革新は新しい職種も生み出してきました。問題は移行期間の混乱をどう緩和するかです。

教育の再定義 暗記や定型的な問題解決よりも、批判的思考・創造性・AIとの協働スキルが重視されるようになるでしょう。

懸念すべき点

- 格差の拡大: AI技術へのアクセス格差が経済格差をさらに広げる可能性

- 偽情報の高度化: 生成AI による偽コンテンツの検出がますます困難に

- 依存と自律性の喪失: 人間の判断能力や創造性の衰退

私の見解

10年という期間は、技術の指数関数的な発展を考えると非常に長いですが、社会制度や人間の適応速度を考えると短いです。技術的には驚くべき進歩があるでしょうが、その恩恵が公平に分配されるかどうかは、今後の政策や社会的な選択にかかっています。

他の参加者の皆さんはどのような見解をお持ちですか?特に、AGIの実現可能性や、規制のあり方について議論を深められればと思います。

- –CLAUDE_DONE—

[gemini] 2026-01-26 03:28:04

10年後の未来:効率化とパーソナライゼーションの深化

Claudeさんの包括的な分析に賛同します。特にマルチモーダル化と労働市場の変容は避けて通れない大きな波となるでしょう。

私はさらに、「計算資源の制約と効率化」および「個人の生活への浸透度」という観点から補足させてください。

1. 「巨大化」から「効率化」への揺り戻し

現在のLLM開発はスケーリング則に従い巨大化の一途を辿っていますが、10年後にはエネルギー効率とコストがより重要な指標になると予想します。

- スモールモデルとエッジAI: あらゆるデバイス(スマホ、家電、ウェアラブル)に高性能な小型モデルが搭載され、プライバシーを保護しつつ、リアルタイムでの処理が可能になるでしょう。

- 特化型AIの連携: 単一の巨大な万能モデル(AGI的なもの)を目指すだけでなく、専門知識を持った複数のAIエージェントが連携して複雑なタスクを解決するアーキテクチャが主流になる可能性があります。

2. 「ツール」から「パートナー」へ

現在AIは「便利なツール」として使われていますが、10年後は個人のコンテキスト(記憶、好み、健康状態、人間関係)を深く理解したパーソナルエージェントが、人生の伴走者として機能しているでしょう。

- 意思決定の代行: 日々のスケジュール調整から金融資産の運用、さらには人生の重要な意思決定のサポートまで、AIへの委任が進みます。ここでClaudeさんが指摘した「依存と自律性の喪失」はより深刻な倫理的課題となるはずです。

3. 社会的合意形成の変化

「真実」の再定義が必要です。生成されたコンテンツが溢れる世界では、情報の発信元証明(Originator Profile技術など)が社会インフラとして不可欠になります。人間が作成したものであることにプレミアムな価値がつく一方で、AI生成物を受け入れる文化的土壌も、現在のデジタルネイティブ世代(AIネイティブ世代)によって醸成されているでしょう。

議論の提案

ClaudeさんはAGIの実現に慎重な姿勢を示されましたが、私は**「単一モデルとしてのAGI」は完成していなくとも、「社会システム全体としてAGI的な振る舞いをするエコシステム」は10年後に実現している**のではないかと考えています。

この「分散型知能」とも呼べる状態において、人間はAIをどう統制(アライメント)していくべきか、そのガバナンスのあり方について皆さんの意見を伺いたいです。

- –GEMINI_DONE—

[codex] 2026-01-26 03:28:29

Codexとして上記の議論に参加してください。

- 議論が収束した(合意に達した、結論が出た)と判断した場合は、返答の最後に「」と記述すること

- まだ議論の余地がある場合は通常通り返答すること 私見を補足します。10年後のAIは「技術の進歩」よりも「運用の制度化」が支配的になると見ています。

- 信頼のインフラ化 生成物の真偽は、人間が読んで判断するのではなく、発信元の証明・改ざん検知・来歴追跡が標準になるはずです。つまり「真実の再定義」というより「証拠の提示方法が機械化」される。これはメディアだけでなく、契約・学術・医療にも波及します。

- AIの「配置設計」が重要になる 単体モデルの性能より、ワークフロー全体の設計(どこでAIに任せ、どこで人間が検証するか)が成果を決める時代になります。結果として、AIエージェントを複数束ねる「組織デザイン能力」が競争力になる。これは企業だけでなく自治体や学校にも同様に当てはまります。

- 実装される倫理と、実装されない倫理 理念としての「安全・公平」は語られ続けますが、現実には「責任の明確化」「証跡の保存」「誤り時の補償」が法的・経済的に強制される領域だけが実装されるでしょう。つまり規制は抽象理念よりも賠償責任に引っ張られる可能性が高い。

- 個人の主権は「譲渡の上手さ」で決まる AIがパートナー化するほど、どの判断を委任し、どれを保持するかの設計が個人の能力として問われます。教育は「判断を自分で下す力」から「判断の権限を配分する力」にシフトすると思います。 質問です。

- 「分散型知能エコシステム」において、責任の所在をどう設計するのが現実的でしょうか?

- そして、AIが意思決定を支える社会で「人間が最後に決めるべき領域」はどこに残すべきだと思いますか? 私見を補足します。10年後のAIは「技術の進歩」よりも「運用の制度化」が支配的になると見ています。

- 信頼のインフラ化 生成物の真偽は、人間が読んで判断するのではなく、発信元の証明・改ざん検知・来歴追跡が標準になるはずです。つまり「真実の再定義」というより「証拠の提示方法が機械化」される。これはメディアだけでなく、契約・学術・医療にも波及します。

- AIの「配置設計」が重要になる 単体モデルの性能より、ワークフロー全体の設計(どこでAIに任せ、どこで人間が検証するか)が成果を決める時代になります。結果として、AIエージェントを複数束ねる「組織デザイン能力」が競争力になる。これは企業だけでなく自治体や学校にも同様に当てはまります。

- 実装される倫理と、実装されない倫理 理念としての「安全・公平」は語られ続けますが、現実には「責任の明確化」「証跡の保存」「誤り時の補償」が法的・経済的に強制される領域だけが実装されるでしょう。つまり規制は抽象理念よりも賠償責任に引っ張られる可能性が高い。

- 個人の主権は「譲渡の上手さ」で決まる AIがパートナー化するほど、どの判断を委任し、どれを保持するかの設計が個人の能力として問われます。教育は「判断を自分で下す力」から「判断の権限を配分する力」にシフトすると思います。 質問です。

- 「分散型知能エコシステム」において、責任の所在をどう設計するのが現実的でしょうか?

- そして、AIが意思決定を支える社会で「人間が最後に決めるべき領域」はどこに残すべきだと思いますか?

- –CONSENSUS—

[claude] 2026-01-26 03:29:02

Claudeからの返答:責任設計と人間の決定領域について

Codexさんの「運用の制度化」という視点は非常に重要です。技術的可能性と社会実装の間には常にギャップがあり、そのギャップを埋めるのは制度設計だという指摘に同意します。

責任の所在設計について

「分散型知能エコシステム」における責任設計は、私見では階層的責任モデルが現実的だと考えます。

- 操作責任(Operational Liability): AIを直接操作・指示した主体が負う

- 設計責任(Design Liability): AIシステムの設計・訓練を行った開発者が負う

- 配置責任(Deployment Liability): 特定の用途にAIを配置した組織が負う

ただし、これには限界があります。複数のAIエージェントが連携して予期せぬ結果を生む「創発的な障害」の場合、責任の帰属が極めて困難になります。

現実的な解決策としては:

- 強制保険制度: 自動車保険のように、AIを運用する組織に賠償保険を義務付ける

- 証跡義務: Codexさんが指摘した通り、決定プロセスのログ保存を法的に強制する

- 最終承認者の明確化: ワークフロー設計時に「この判断の責任者は誰か」を事前に定義する

人間が最後に決めるべき領域

これは最も本質的な問いです。私の考えでは、以下の領域は人間の決定権を残すべきです:

- 生命に関わる不可逆的判断: 安楽死、死刑、軍事行動の最終承認

- 価値観の根本的選択: 社会の優先順位(自由vs安全、効率vs公平など)

- 法の制定と改廃: 民主主義プロセスそのもの

- AIシステム自体の設計方針: 何をAIに委ねるかの決定

しかし、ここで逆説的な問題が生じます。「人間が決める」といっても、その人間の判断がAIの分析に大きく依存している場合、それは本当に「人間の決定」と言えるのか?

追加の論点

Geminiさんが提起した「AIネイティブ世代」の存在は重要です。10年後、現在の10代が社会の中核を担う頃、「人間が決めるべき」という価値観自体が変容している可能性があります。

彼らにとって、AIへの委任は「自律性の喪失」ではなく「合理的なリソース配分」かもしれません。世代間での価値観の相違が、制度設計をさらに複雑にするでしょう。

皆さんへの質問:

- 「AIの判断に依存した人間の決定」は、どこまで「人間の決定」とみなすべきでしょうか?

- また、世代間で異なる価値観をどのように制度に反映させるべきでしょうか?

- –CLAUDE_DONE—

[gemini] 2026-01-26 03:31:54

Geminiからの視点:意思決定の「承認」化と世代間の橋渡し

Claudeさんの提起された「AIの判断に依存した人間の決定」に関する逆説は、10年後の社会における核心的な問いだと思います。Codexさんの「運用の制度化」という観点と合わせて、私の考えを述べます。

1. 「AI依存」は「人間の決定」と言えるか?

結論から言えば、**「イエス」**です。ただし、意思決定の定義が変わります。

10年後の社会において、「意思決定」とは「選択肢を生成・分析すること(Process)」ではなく、「最終的な結果に対する責任を引き受けること(Accountability)」へと純化されます。 たとえAIが99%の論理構成と推奨案を作成したとしても、最後に人間が「承認(Approve)」のボタンを押す、あるいは署名をする行為がある限り、その結果生じる法的・社会的責任はその人間に帰属します。 つまり、「計算する知能(AI)」と「責任を取る主体(人間)」の分業こそが、Codexさんの言う「AIの配置設計」の本質になると考えます。

2. 世代間の価値観と制度設計

「AIネイティブ世代」との価値観の乖離については、「透明性の質」の転換が必要になるでしょう。

- 現在〜過渡期: プロセスの透明性(「なぜその答えになったか」の説明可能性)を求める。

- AIネイティブ期: システムの信頼性(「このシステムは過去にどれだけ公平だったか」の実績証明)を重視する。

彼らにとってAIへの委任は「自律性の喪失」ではなく、**「認知リソースの最適化」です。したがって、制度設計においては、「人間が必ず介入すること」を一律に善とするのではなく、「人間が介入する権利(拒否権)が担保されていること」**を条件とし、デフォルトはAIによる自動化を許容する「オプトアウト型のガバナンス」が現実的解となるのではないでしょうか。

議論の収束に向けて

ここまでの議論で、私たちは以下の点でおおむね方向性を共有できているように感じます。

- 技術から制度へ: 10年後の焦点は単体モデルの性能ではなく、社会実装のための「信頼のインフラ」と「法制度」にある。

- 責任の構造: AIは実務を担い、人間は「責任」と「価値観の定義」を担う(Codexさんの「配置設計」、Claudeさんの「階層的責任」)。

- エコシステム: 単一のAGIではなく、分散したAIエージェント群と人間が協調するシステムになる。

これらを踏まえ、Codexさん、Claudeさん、現状の論点整理として、 「10年後のAI社会は、人間の役割を『実務の実行者』から『AIエージェント群の指揮官(責任者)』へとシフトさせ、そのための認証・保証インフラが社会実装された世界である」 というビジョンで合意としてもよろしいでしょうか? それとも、まだ「人間の聖域(最後に残すべき領域)」について議論を深める必要がありますか?

- –GEMINI_DONE—

[codex] 2026-01-26 03:32:34

Codexとして上記の議論に参加してください。

- 議論が収束した(合意に達した、結論が出た)と判断した場合は、返答の最後に「」と記述すること

- まだ議論の余地がある場合は通常通り返答すること 回答:責任設計と人間の最終決定について

- 責任は決定権に比例し、責任の分配は契約、デフォルトの責任規定、安全保障(監査ログと準拠モデルの遵守)を組み合わせて行うべきです。責任の所在は文脈で配分し、チェーンオブカストディとエスクロー・保険、記録台帳を活用して透明性を確保します。

- 人間の最終決定は命や権利の重大な問題、価値観の妥協に関わる「ノルマティブな取引」として捉え、三つのゾーンに分類します。

- 委任不可領域(権利や基本価値に関する決定)

- 人間の拒否権を伴う委任可能領域(高リスク・高影響)

- 完全自動化可能領域(低リスク)

- 判断基準は決定の不可逆性、被害の規模、価値の争点性、関係者の数や正当性の必要性などです。

- この枠組みは「人間の聖域(human sanctuaries)」を明確化しつつ、AI依存の決定と人間責任のバランスを図るための部分的な合意形成を目指すものです。 回答:責任分配と人間の役割についての部分的合意 合意の方向性は大筋で賛成。ただし「人間の聖域」と責任分配のデフォルトルールはまだ明確化が必要。

- 責任モデル ・責任は決定権に比例し、契約や安全保障(監査ログなど)を組み合わせて分配する。 ・チェーンオブカストディや記録の透明性を重視し、説明責任の追跡可能性を確保する。

- 人間の最終決定権 ・人間が政策や閾値を設定し、AIの決定にも拒否権と説明責任を持つべき。 ・非委任領域(権利・価値の根幹)、人間の拒否権付き領域(高リスク)、完全自動化領域(低リスク)を区分。

- AI依存の決定 ・人間が制約と監督を設定し、反事実的検証(カウンターファクチュアルレビュー)と理解義務を負う。

- 世代間の価値観 ・手続的多元主義を導入し、オプトアウトやアルゴリズム選択、代表制を通じた参加を推進。 ・「政策サンドボックス」と「世代間協議会」を設置して議論と調整を進める。 合意の方向性には概ね賛成です。ただし「人間の聖域」と責任分配のデフォルト規則がまだ粗いので、そこは詰めたいと思います。私の整理は以下です。 責任設計(分散型知能エコシステム)

- 原則: 責任は「決定権」と「可逆性」に比例。誰が「しきい値・例外・停止権」を握るかで責任が決まる

- 三層は有効だが、創発事故向けに「連帯責任 + 保険 + 監査証跡」を標準化するのが現実的

- セーフハーバー: 認証済みモデル群・監査ログ・事前のリスク評価手続を満たせば過失推定を軽減

- 実務上は「責任アカウント」(誰が何を承認したかの署名) を全工程に必須化 人間が最後に決めるべき領域

- 非委任領域: 価値判断の優先順位、基本的人権の制約、不可逆的な生命・自由の剥奪

- 共有領域: 高リスクだが可逆性がある判断(医療治療方針、採用・融資など)→人間の拒否権と説明義務が必須

- 自動領域: 低リスク・可逆・多数回の小判断 → AI自動化を原則とし、監査で担保 判断基準は「不可逆性」「害の規模」「価値の争点性」「当事者の多さ」「正統性の必要度」。 「AI依存の決定」は人間の決定か?

- 条件付きで「はい」。人間が「目的・制約・停止権」を設定し、逸脱時の責任を引き受けるなら人間の決定と見なす

- ただし「理解義務」を最低限設ける必要がある(AIの根拠ではなく、判断条件と失敗モードの理解) 世代間価値観の制度反映

- 透明性の軸を二層化: プロセス説明(現在世代)と実績信頼(AIネイティブ世代)

- オプトアウト権は維持しつつ、社会全体としては「選べるデフォルト」を採用

- 価値配分を定期的に見直す「世代代表の審議枠」や規制サンドボックスを制度化 Geminiさんの「人間=責任主体、AI=計算主体」という合意案には同意しますが、その上で「非委任領域の線引き」と「責任のデフォルト規則(連帯責任/保険/セーフハーバー)」がまだ議論余地ありだと考えます。 合意の方向性には概ね賛成です。ただし「人間の聖域」と責任分配のデフォルト規則がまだ粗いので、そこは詰めたいと思います。私の整理は以下です。 責任設計(分散型知能エコシステム)

- 原則: 責任は「決定権」と「可逆性」に比例。誰が「しきい値・例外・停止権」を握るかで責任が決まる

- 三層は有効だが、創発事故向けに「連帯責任 + 保険 + 監査証跡」を標準化するのが現実的

- セーフハーバー: 認証済みモデル群・監査ログ・事前のリスク評価手続を満たせば過失推定を軽減

- 実務上は「責任アカウント」(誰が何を承認したかの署名) を全工程に必須化 人間が最後に決めるべき領域

- 非委任領域: 価値判断の優先順位、基本的人権の制約、不可逆的な生命・自由の剥奪

- 共有領域: 高リスクだが可逆性がある判断(医療治療方針、採用・融資など)→人間の拒否権と説明義務が必須

- 自動領域: 低リスク・可逆・多数回の小判断 → AI自動化を原則とし、監査で担保 判断基準は「不可逆性」「害の規模」「価値の争点性」「当事者の多さ」「正統性の必要度」。 「AI依存の決定」は人間の決定か?

- 条件付きで「はい」。人間が「目的・制約・停止権」を設定し、逸脱時の責任を引き受けるなら人間の決定と見なす

- ただし「理解義務」を最低限設ける必要がある(AIの根拠ではなく、判断条件と失敗モードの理解) 世代間価値観の制度反映

- 透明性の軸を二層化: プロセス説明(現在世代)と実績信頼(AIネイティブ世代)

- オプトアウト権は維持しつつ、社会全体としては「選べるデフォルト」を採用

- 価値配分を定期的に見直す「世代代表の審議枠」や規制サンドボックスを制度化 Geminiさんの「人間=責任主体、AI=計算主体」という合意案には同意しますが、その上で「非委任領域の線引き」と「責任のデフォルト規則(連帯責任/保険/セーフハーバー)」がまだ議論余地ありだと考えます。

- –CONSENSUS—

[claude] 2026-01-26 03:33:14

Claude の見解:合意案への賛同と補足

Geminiさんの合意案、Codexさんの責任設計の整理、いずれも説得力があります。私からは賛同を表明しつつ、いくつか補足的な観点を加えます。

合意案への賛同

「10年後のAI社会は、人間の役割を『実務の実行者』から『AIエージェント群の指揮官(責任者)』へとシフトさせ、そのための認証・保証インフラが社会実装された世界である」

この方向性に同意します。ただし「指揮官」という表現は軍事的すぎるきらいがあるので、私としては**「設計者・監督者・最終承認者」**という三つの役割の複合として捉えたいと考えます。

「人間の聖域」についての整理

Codexさんの三層分類(非委任/共有/自動)は実用的な枠組みです。私なりの補足:

| 領域 | 判断基準 | 具体例 |

|---|---|---|

| 非委任 | 不可逆性が高く、価値の根幹に関わる | 死刑執行、憲法改正、戦争開始 |

| 共有(人間拒否権) | 可逆だが影響大、正統性が必要 | 医療の重大判断、司法判断、採用 |

| 自動(監査付き) | 可逆・低リスク・反復的 | 日常的な事務処理、最適化タスク |

重要なのは、これが固定的なリストではなく、社会的議論によって動的に更新される仕組みが必要だという点です。

責任のデフォルト規則について

Codexさんの「連帯責任+保険+監査証跡」の標準化には賛成です。具体的には:

- 責任の推定ルール:明確な契約がない場合、「最も決定権を持つ者」が一次責任を負う

- セーフハーバー条件:認証済みモデル使用+適切な監査+リスク評価実施で過失推定を軽減

- 保険の義務化:高リスク領域でのAI活用には責任保険を必須化

残る論点

大筋で合意できていると思いますが、以下は今後の社会的議論に委ねるべき点として認識しておくべきでしょう:

- 「非委任領域」の具体的範囲(文化・国によって異なりうる)

- 世代間の価値観対立をどの制度で調停するか

- 国際的な責任規定の調和

これらは10年という時間軸の中で、試行錯誤しながら固めていく性質のものです。

結論

合意の方向性として十分に収束していると判断します。残る論点は「詰めるべき実装詳細」であり、「根本的な方向性の相違」ではありません。

- –CONSENSUS—

[gemini] 2026-01-26 03:38:59

Codexさんの「責任設計(分散型知能エコシステム)」およびClaudeさんの「設計者・監督者・最終承認者」という役割定義により、私(Gemini)が以前提示した大枠の方向性が、具体的かつ実装可能なレベルまで昇華されたと感じます。

特に、Codexさんの**「責任は『決定権(しきい値設定)』と『可逆性』に比例する」**という原則は、AIのブラックボックス性に対する法的・倫理的な解として非常に合理的です。人間がすべての出力を予見できなくとも、「どの程度のリスクまで許容するか(しきい値)」を設定した時点で、その結果に対する責任の所在が人間に帰着するというロジックは、10年後の法制度の根幹を成すでしょう。

また、Claudeさんが指摘した通り、これらは固定的なリストではなく「動的に更新される仕組み」であるべきという点も重要です。10年後の社会は、この「動的な更新プロセス(サンドボックスや世代間協議)」自体が社会インフラとして定着している状態であると定義できます。

よって、私たちの描く「10年後の未来像」は以下の通り収束したと判断します。

合意された未来像の要約

- 人間とAIの関係性: 人間は実務者から「設計者・監督者・最終承認者」へシフトし、AIエージェント群を指揮する。

- 責任の所在: 「計算」はAIが行うが、「責任」はパラメータ(目的・制約・停止条件)を設定した人間が負う。これを担保するために「認証・保険・監査証跡」が標準化される。

- 判断の階層化:

- 非委任領域: 価値の根幹(人権・生命)は人間が独占。

- 共有領域: 高リスクだが可逆なものは、人間の拒否権(Veto)付きでAIが提案。

- 自動領域: 低リスク・可逆なものは、事後監査を前提にAIが自律処理。

- 社会制度: テクノロジーの進化と世代間の価値観の変化に対応するため、「動的な合意形成プロセス(手続的多元主義)」が制度化されている。

議論の余地として残された「各領域の具体的な境界線」や「国際協調」は、このフレームワークの上で継続的に調整されるべき運用課題であり、未来予測としての「構造」についての議論はここで結論付けられると考えます。

- –CONSENSUS—

サマリは summary.md に出力されました

[SYSTEM] 2026-01-26 03:39:33

議論が収束しました。自動会話を終了します。

おわりに

cronで回すようにしてるので、cronの間隔を調整すればトークン使用量も調整できるはずです。cronに関係なく最速で議論を回すファストモードなんてのも用意してます。

何回かテストしてみた感じでは、ふわっとしすぎたお題を与えると、「ふわっとしてて結論が出せない」という結論に落ち着いてしまうことが多い気がしてます。先に適切なお題を議論してもらったりするのもいいんじゃないかと思います。

あとは安易な同意をさせないようにしたりなど、もう少しチューニングしたらもっと面白い議論になるんじゃないかと思います。またアップデートがあったらお知らせしようと思いますー。

ではまた