IDチームの前田です。Cursor使っていますか? 今回はCursorのプライバシーモードの挙動について調査し、実際に不明な点を問い合わせて確認したので、そちらについて書きます。

筆者はCursorを正式リリース前から利用していたので、昨今のCursorの盛り上がりをインディーズバンドの古参ファンのような目線で見ております。

3行まとめ

- 自前でAIサービスのAPIキーを持ち込んでも、Cursorのインフラを経由して各AIサービスにアクセスしている

- Cursor自体はデータを保持しないが、Cursorから先のAIサービスのデータの扱いはサービスごとで異なる

- ユーザのリクエストはCursorのバックエンドサーバを経由することで、質の高い回答、素早いレスポンスを得ている

AIコードエディタ Cursor とは

- Cursorエディタは、AI技術を統合したコードエディタで、プログラミングの効率化を目的としています。VSCodeをベースに開発されており、コード生成や自動修正などの高度なAI機能を備えています。

- 公式サイト: https://www.cursor.com/ja

Cursor の Privacy Modeとは

- Cursor に存在するコードの扱いに関する設定です。

- エディタ上ではPrivacy Mode enabledにするとコードが保存されないと記載されているのみで、具体的な説明は特にありません。

If on, none of your code will be stored by us. If off, we may save prompts and collect telemetry data to improve Cursor. Read more.

Read more.をクリックすると https://www.cursor.com/ja/privacy に遷移します。

リンク先のページにPrivacy Modeの挙動についてまとまっています。

Privacy Modeの説明

原文

TLDR

- If you enable “Privacy Mode” in Cursor’s settings: zero data retention will be enabled, and none of your code will ever be stored or trained on by us or any third-party.

- If you choose to keep “Privacy Mode” off, we collect telemetry and usage data. This may include prompts, editor actions, code snippets, and edits made to this code. We use this data to evaluate and improve our AI features.

- With “Privacy Mode” off, if you use autocomplete, Fireworks (our inference provider) may also collect prompts to improve inference speed.

Other notes

- Even if you use your API key, your requests will still go through our backend! That’s where we do our final prompt building.

- If you choose to index your codebase, Cursor will upload your codebase in small chunks to our server to compute embeddings, but all plaintext code ceases to exist after the life of the request. The embeddings and metadata about your codebase (hashes, file names) may be stored in our database, but none of your code is.

- We temporarily cache file contents on our servers to reduce latency and network usage. The files are encrypted using unique client-generated keys, and these encryption keys only exist on our servers for the duration of a request. All cached file contents are temporary, never permanently stored, and never used as training data when privacy mode is enabled.

日本語訳

要約

- Cursorの設定で「プライバシーモード」を有効にすると:データ保持はゼロになり、あなたのコードが当社や第三者によって保存されたり、トレーニングに使用されたりすることは一切ありません。

- 「プライバシーモード」をオフにしておくと、当社はテレメトリーや使用状況データを収集します。これには、プロンプト、エディタのアクション、コードスニペット、このコードに加えられた編集などが含まれる場合があります。当社はこのデータを使用してAI機能を評価・改善します。

- 「プライバシーモード」がオフの状態で自動補完を使用すると、Fireworks(当社の推論プロバイダー)もプロンプトを収集して推論速度を向上させる場合があります。

その他の注意点

- APIキーを使用しても、リクエストは当社のバックエンドを経由します!そこで最終的なプロンプト構築を行います。

- コードベースのインデックス作成を選択すると、Cursorはエンベディングを計算するためにコードベースを小さなチャンクに分けて当社のサーバーにアップロードしますが、すべてのプレーンテキストコードはリクエストの寿命が終了すると存在しなくなります。コードベースに関するエンベディングとメタデータ(ハッシュ、ファイル名)は当社のデータベースに保存される場合がありますが、あなたのコードは一切保存されません。

- レイテンシーとネットワーク使用量を削減するために、当社はサーバーにファイル内容を一時的にキャッシュします。ファイルはクライアント生成の一意のキーを使用して暗号化され、これらの暗号化キーはリクエストの期間中のみ当社のサーバーに存在します。キャッシュされたすべてのファイル内容は一時的なものであり、永続的に保存されることはなく、プライバシーモードが有効な場合はトレーニングデータとして使用されることはありません。

Cursorの挙動

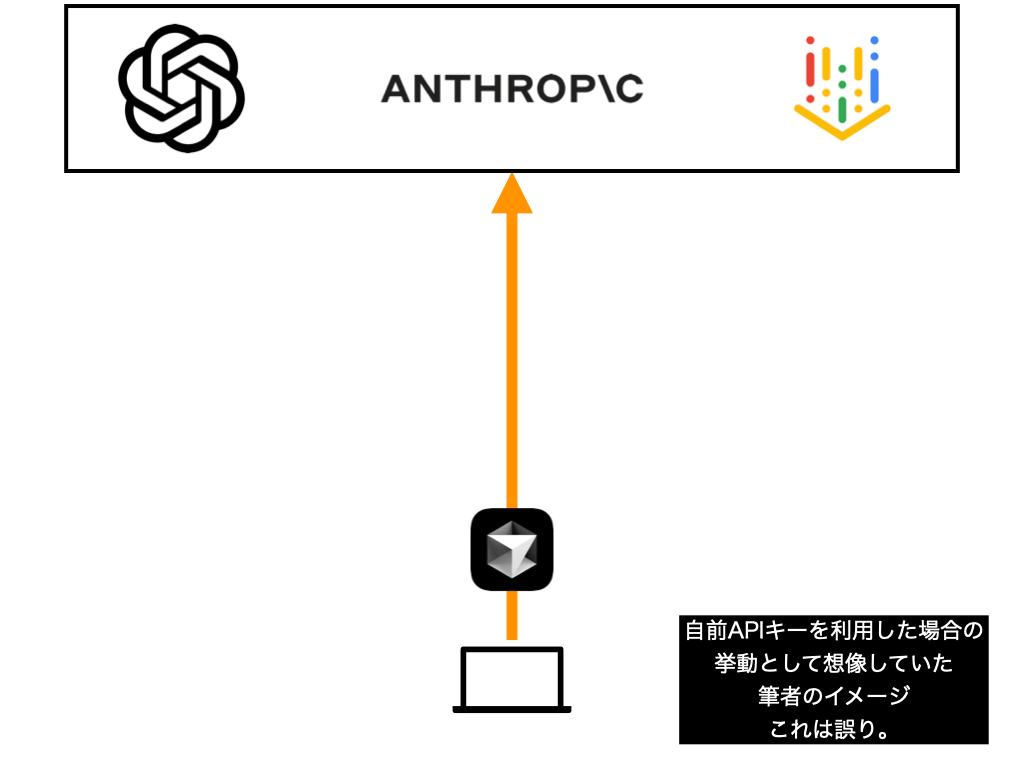

Privacy Modeの挙動を確認していて、筆者は勘違いしていたことがありました。

各AIサービスのAPIキーを持ち込んで利用している場合は、リクエストは直接AIサービスにアクセスしているものと勝手に思っていましたが、これは誤った理解でした。

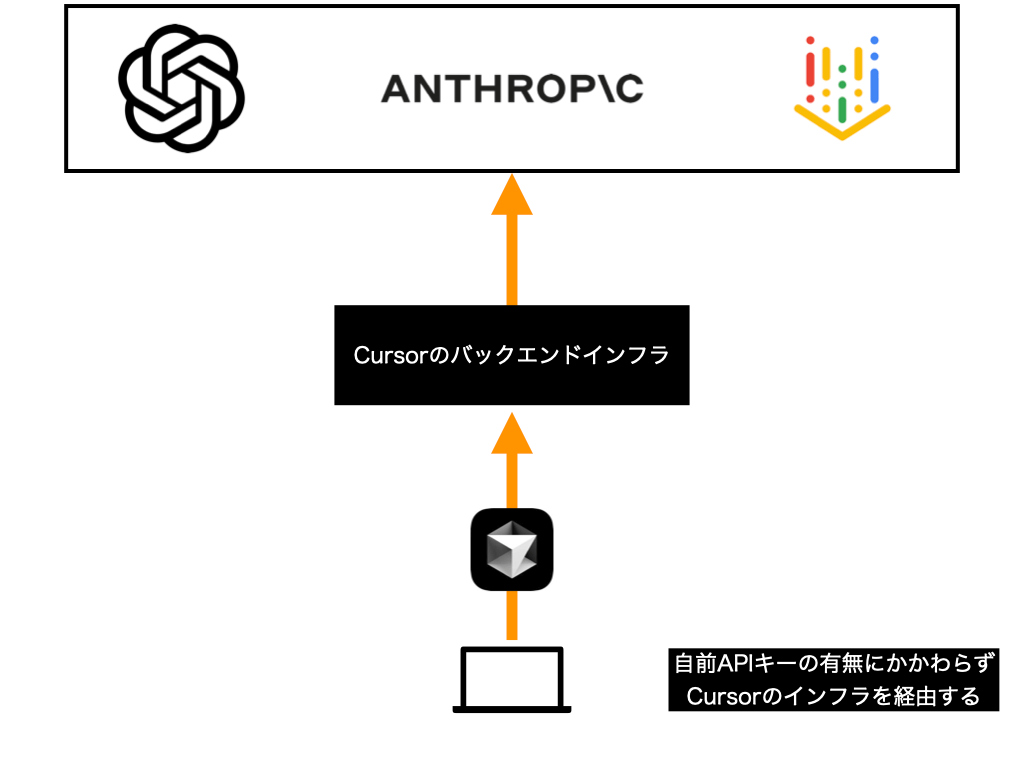

持ち込んだ各AIサービスのAPIキーの有無にかかわらず、リクエストはCursorのバックエンドインフラを経由して各AIサービスにアクセスしているとのことです。

以下では、バックエンドインフラでの挙動について説明します。

Cursorのバックエンドインフラでは何が行われているか

これも前述のページに記載されていますが、 このバックエンドインフラを利用していることがCursorエディタが他のAIエディタよりも提案されるコードの品質が高く、レスポンスも早い要因となっているようです。

バックエンドサーバの処理の概要

- 最終的なプロンプト構築

- コードベースのインデックス作成処理

- ファイルキャッシュの処理

持ち込んだ各AIサービスのAPIキーを利用しているのに、Cursorで障害が発生すると処理速度が落ちたり、回答が返ってこなくなるのはこの構成によるものと考えられます。

Cursorのバックエンドインフラの先の各AIサービスでのデータの取り扱い

Cursor自体がデータを保存しないことは分かりましたが、その先に利用している各種AIサービスについてはよく分からなかったので、問い合わせをしたところ下記のような返答が返ってきました。ちなみに利用者が急増しているようで、問い合わせも殺到しているらしく問い合わせして一次回答が返ってくるまで3週間ほど要しました

When Privacy Mode is enabled in Cursor, we ensure that none of your code is stored by Cursor or any third parties.

You can learn more about our Privacy Mode at:https://docs.cursor.com/account/privacy

https://cursor.com/security#privacy

And our general security practices at:

なんと、別のページにもまとめがあったことが分かりました。以下にその内容を紹介します。

Cursor Privacy Mode時のAIサービスの挙動

2025年02月28日時点の https://cursor.com/security#privacy 情報を翻訳

| AIサービス | Privacy Mode有効時の挙動 |

|---|---|

| AWS | コードデータを参照する(Sees code data)。Cursorのインフラは主にAWS上でホスティングされており、ほとんどのサーバーは米国にあり、一部のレイテンシーが重要なサーバーはアジア(東京)とヨーロッパ(ロンドン)のAWSリージョンに配置されています |

| Fireworks | コードデータを参照する(Sees code data)。カスタムモデルは米国、アジア(東京)、ヨーロッパ(ロンドン)のサーバーでホスティングされています。Fireworksはプライバシーモードが無効の場合のみ、推論を高速化するためにコードデータを保存することがあります |

| OpenAI | コードデータを参照する(Sees code data)。AIレスポンスを提供するためにOpenAIの多くのモデルに依存しています。チャットで他のモデル(AnthropicやGoogle等)を選択していても、要約などのためにOpenAIにリクエストが送信される場合があります。OpenAIとはゼロデータ保持契約を結んでいます |

| Anthropic | コードデータを参照する(Sees code data)。AIレスポンスを提供するためにAnthropicの多くのモデルに依存しています。チャットで他のモデル(OpenAIやGoogle等)を選択していても、要約などのためにAnthropicにリクエストが送信される場合があります。Anthropicとはゼロデータ保持契約を結んでいます |

| Google Cloud’s Vertex API (Gemini) | コードデータを参照する(Sees code data)。AIレスポンスを提供するためにGoogle CloudのVertex API経由で提供されるGeminiモデルに依存しています。チャットで他のモデル(OpenAIやAnthropic等)を選択していても、要約などのためにGoogle Cloud Vertex APIにリクエストが送信される場合があります。Vertexとはゼロデータ保持契約を結んでいます |

| Turbopuffer | 難読化されたコードデータを保存する(Stores obfuscated code data)。インデックス化されたコードベースの埋め込みと、埋め込みに関連するメタデータ(難読化されたファイル名)は、米国のGoogle Cloudサーバー上のTurbopufferに保存されます。ユーザーはコードベースのインデックス作成を無効にすることができます |

| Exa/SerpApi | 検索リクエストを参照する(See search requests)。Webの検索機能に使用されます。検索リクエストはコードデータから派生する可能性があります(例:チャットで「@web」を使用すると、別の言語モデルがメッセージ、会話履歴、現在のファイルを調べて何を検索するかを決定し、Exa/SerpApiは結果の検索クエリを参照します)。 |

2025年3月27日現在、コーディングに関してはAnthropicのClaude 3.7 Sonnet一択かと思いますので、他のモデルは削除して、Anthropicのデータ取り扱いポリシーの確認しておくことをお勧めします。

Cursor BusinessのPrivacy mode

公式ドキュメント のPrivacy Mode Guaranteeで「Team」と記載されている箇所がありますが、これはCursor Businessの機能を指していると考えられます。Cursor Businessの組織に参加しているユーザーは、たとえ個人設定でPrivacy modeをdisabledにしていたとしても、5分以内に組織のポリシーによってPrivacy modeが適用される仕組みが説明されています。

For team-level privacy mode enforcement, each client pings the server every 5 minutes to check if the user is on a team that enforces privacy mode. If so, it overrides the client’s privacy mode setting. To prevent cases where the privacy mode ping by the client fails for any reason, our server also, in the hot path, checks whether the user is part of a team that enforces privacy mode, and if so treats the request as if it is on privacy mode even if the header says otherwise. On latency-sensitive services, we cache this value for 5 minutes, and for any cache miss we assume that the user is on privacy mode. All in all, this means that when a user joins a team, they will be guaranteed to be on privacy mode at the very latest 5 minutes after joining the team.

チーム単位のプライバシーモード強制のために、各クライアントは5分ごとにサーバーへ接続し、ユーザーがプライバシーモードを強制するチームに所属しているかをチェックします。もしそうであれば、クライアントのプライバシーモード設定を上書きします。クライアントからのプライバシーモードの確認が何らかの理由で失敗するケースを防ぐため、サーバーも処理の最中に、ユーザーがプライバシーモードを強制するチームの一員かどうかを確認し、もしそうであればヘッダーが別の設定を示していても、そのリクエストをプライバシーモードであるかのように扱います。レイテンシーに敏感なサービスでは、この値を5分間キャッシュし、キャッシュミスが発生した場合はユーザーがプライバシーモードであると想定します。これらすべてにより、ユーザーがチームに参加した場合、遅くともチーム参加から5分後には確実にプライバシーモードが適用されることになります。

Privacy modeを利用すれば安全か

これまで調査した情報から、2025年3月28日現在、Privacy modeを有効にし、利用するAIサービスを限定していれば一定の安全性は確保できると考えられます。

ただしCursorのセキュリティページでは機密情報に関しては注意して扱うように記載されています。

While we have several large organizations already trusting Cursor, please note that we are still in the journey of growing our product and improving our security posture. If you’re working in a highly sensitive environment, you should be careful when using Cursor (or any other AI tool). We hope this page gives insight into our progress and helps you make a proper risk assessment.

現在、すでに多くの大規模組織がCursorを信頼してご利用いただいておりますが、私たちはまだ製品の成長とセキュリティ態勢の改善の途上にあることをご留意ください。非常に機密性の高い環境で作業されている場合は、Cursor(または他のAIツール)を使用する際に注意が必要です。このページが私たちの進捗についての洞察を提供し、適切なリスク評価をお手伝いできることを願っています。

https://www.cursor.com/ja/security#privacy

今回はAIエディタ CursorのPrivacy mode の挙動を確認し、Cursorを経由したAIサービスでのデータの扱いについて調査しました。また、Cursorが他のAIエディタと比較して優れている理由についても考察してみました。それでは!